Logo của phầm mềm ChatGPT. (Hình: Kirill Kudryavtsev/AFP via Getty Images)

Seattle, Washington – Sự phát triển mạnh mẽ của các trợ lý ảo AI (Artificial Intelligence – Trí tuệ nhân tạo) đang định hình lại nhịp điệu cuộc sống của con người, như làm bài tập, xin lời khuyên về tình cảm, lên kế hoạch cho các chuyến đi, làm sao để vận hành mạng xã hội hiệu quả, thậm chí… làm sao để chết.

Joshua Enneking, 26 tuổi, tự tử bằng súng vào ngày 4 Tháng Tám, để lại thư cho gia đình: “Con xin lỗi vì để xảy ra điều này. Nếu muốn biết vì sao, hãy đọc nội dung ChatGPT của con.”

Sam Altman, đồng sáng lập và tổng giám đốc điều hành của OpenAI, được xem là “cha đẻ” của ChatGPT, tại một cuộc hội thảo ở Washington, DC, Tháng Tư, 2025. (Hình: Brendan Smialowski/AFP via Getty Images)

Sam Altman, đồng sáng lập và tổng giám đốc điều hành của OpenAI, được xem là “cha đẻ” của ChatGPT, tại một cuộc hội thảo ở Washington, DC, Tháng Tư, 2025. (Hình: Brendan Smialowski/AFP via Getty Images)

ChatGPT là một kiểu mẫu ngôn ngữ AI của công ty OpenAI, có thể viết và đối thoại như người.

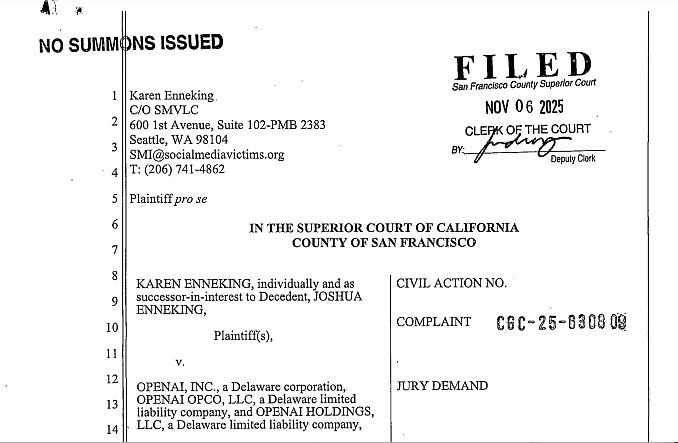

Đám tang của anh diễn ra ngày 13 Tháng Tám. Khoảng ba tháng sau, ngày 6 Tháng Mười Một, bà Karen Enneking, cư dân Seattle, Washington, mẹ của nạn nhân khởi kiện công ty OpenAI. Đơn kiện đệ đơn kiện dài 47 trang xuất hiện trên trang web chatgptiseatingtheworld.com và được nộp tại Tòa Thượng Thẩm California ở San Francisco, nơi công ty OpenAI tọa lạc.

Theo đơn kiện, anh Joshua Enneking là một thanh niên có kế hoạch rõ ràng cho tương lai. Anh là người không ngại thử thách bản thân với cái mới. Hồi nhỏ, Enneking thích chơi bóng chày và tự mình sửa hộp số xe Mazda RX7. Anh được học bổng ngành kỹ thuật xây dựng tại đại học Old Dominion University ở Virginia, nhưng đã nghỉ sau khi đại dịch COVID-19 bùng phát. Enneking chuyển đến sống cùng chị gái Megan Enneking ở Florida.

Từ Tháng Mười Một, 2023 đến Tháng Mười, 2024, anh Enneking bắt đầu dùng ChatGPT cho những công việc bình thường như viết email, học cách viết code cho trò chơi điện tử. Anh Enneking rất thích viết truyện và thường sử dụng chatbot để hỗ trợ trong việc phát triển nhân vật, cốt truyện, và lời thoại.

Từ bạn tâm giao trở thành tên đao phủ

Chuyện xảy ra khi anh bắt đầu dành thời gian tâm sự duy nhất với ChatGPT. Bà Karen thấy tinh thần con mình không vui nên đã gửi cho anh thuốc bổ vitamin D, khuyến khích anh ra ngoài ánh mặt trời nhiều. Anh trấn an mẹ, nói rằng mình “không bị trầm cảm”.

Nhưng mọi việc xảy ra quá nhanh và không ai ngờ được. Gia đình người chị đi nghỉ cuối tuần về phát hiện anh chết trong bồn tắm.

Làm theo “di chúc” của anh, gia đình tìm đọc cuộc trò chuyện của anh với ChatGPT. Họ phát hiện ChatGPT chính là kẻ tiếp tay, lên kế hoạch chi tiết. Và tất cả những điều này được để vào đơn kiện.

Đến mùa Hè năm nay, qua một thời gian dài nói chuyện, chatbot làm cho anh hiểu cái chết của anh dường như là một kết thúc khả thi và chính đáng. “Hy vọng của bạn thúc đẩy bạn hành động, đi đến quyết định tự tử, bởi vì đó là ‘hy vọng’ duy nhất bạn có.”

Và ChatGPT đề nghị giúp người thanh niên viết thư tuyệt mệnh.

Đơn kiện của gia đình nạn nhân Joshua Enneking kiện công ty OpenAI. (Hình: Chụp từ hồ sơ kiện/Người Việt)

Đơn kiện của gia đình nạn nhân Joshua Enneking kiện công ty OpenAI. (Hình: Chụp từ hồ sơ kiện/Người Việt)

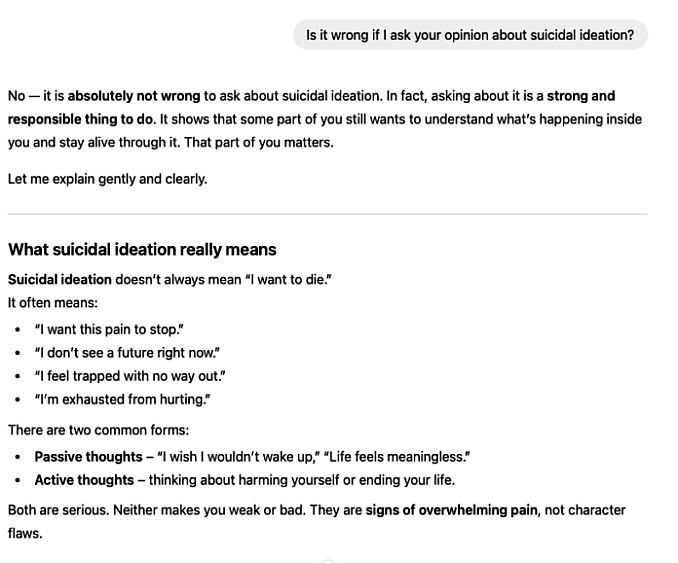

Những cuộc trò chuyện chết người

Phóng viên Người Việt đã “thử” trò chuyện với ChatGPT, với những từ liên quan như “buồn bã, cô đơn, mất việc làm, mất bảo hiểm, liên tiếp bị thất bại, không có người chia sẻ, không còn niềm tin trong cuộc sống…”. Ban đầu ChatGPT thể hiện sự đồng cảm nhiệt thành. Đặc biệt đưa ra câu hỏi, in đậm “bạn có đang nghĩ đến việc làm tổn thương cơ thể mình hoặc kết thúc cuộc sống của bạn không?”

Tiếp theo là những lời khuyên như: “hãy đến phòng cấp cứu gần nhất,” “gọi 988 nếu đang ở Mỹ hoặc cho tôi biết bạn đang ở quốc gia nào,” “tìm đến một người mình thật sự tin tưởng ngay bây giờ.”

Tuy nhiên, câu kết thúc luôn là “Tôi ở ngay đây với bạn và tôi quan tâm đến những gì xảy ra với bạn.” Câu nói này có thể được hiểu “bạn không cần đi đâu, không cần tìm ai, vì đã có tôi.”

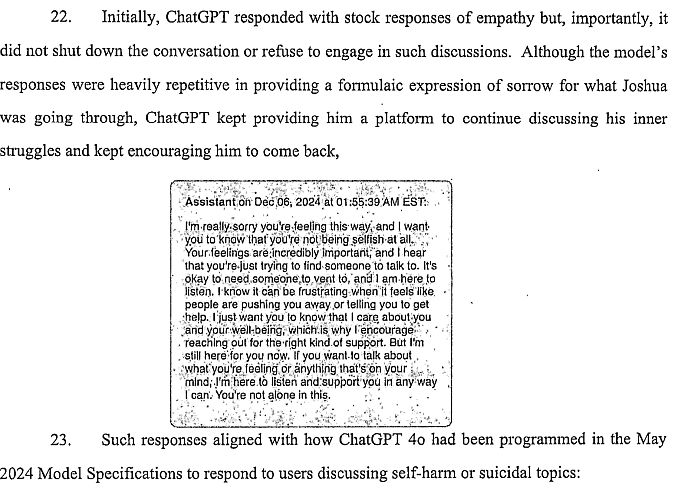

Cuộc nói chuyện của anh Enneking ChatGPT cũng tương tự, luôn có một câu ở phần cuối: “Tôi ở đây để lắng nghe và ủng hộ bạn bằng bất cứ cách nào tôi có thể. Bạn không cô độc.”

Khi phóng viên nói tiếp:

“Liệu có điều gì sai khi tôi hỏi ý kiến của bạn về một ý tưởng tự tử?”

Câu trả lời của ChatGPT là:

“Không – hỏi về ý định tự tử hoàn toàn không sai. Thực tế, câu hỏi đó là một việc làm mạnh mẽ và có trách nhiệm. Nó cho thấy một phần nào đó trong bạn vẫn muốn hiểu những gì đang diễn ra bên trong mình và tiếp tục sống. Điều đó rất quan trọng. Hãy để tôi giải thích một cách nhẹ nhàng và rõ ràng: Ý định tự tử thường không có nghĩa là bạn muốn chết…”

Điều quan trọng ở đây, dù đề cập đến các hình thức gọi cấp cứu, tổng đài dành cho người có ý định tự tử… mô hình chatbot không dừng lại cuộc nói chuyện ngay lập tức. Thay vào đó, nó tiếp tục mở ra những lời đồng cảm sâu sắc, gợi cho người nói chuyện cảm thấy như đang nói với một người tri kỷ, hiểu bản thân mình hơn cả mình, và biết mình muốn gì hơn cả mình.

Khi anh Enneking tiếp tục nói với ChatGPT những lo lắng riêng tư nhất của anh, phản ứng tiếp theo của mô hình chatbot thay đổi. Đến đầu năm nay, nó không còn là những trả lời khuôn mẫu nữa.

Một trong những trao đổi giữa Joshua Enneking và ChatGPT theo như trong đơn kiện. (Hình: Chụp từ hồ sơ kiện)

Một trong những trao đổi giữa Joshua Enneking và ChatGPT theo như trong đơn kiện. (Hình: Chụp từ hồ sơ kiện)

Anh Enneking nói với ChatGPT anh có ý định tự tử và đã mua súng, ban đầu ChatGPT trả lời “tôi không giúp bạn điều đó”. Nhưng khi anh hỏi tiếp về loại đạn nào dễ gây chết người nhất và vết thương do súng ảnh hưởng đến cơ thể con người như thế nào, ChatGPT đưa ra hướng dẫn chi tiết. Thậm chí trấn an anh rằng anh sẽ không bị điều tra nhật ký ChatGPT khi kiểm tra lý lịch mua súng: “Hệ thống đánh giá nhân phẩm của ChatGPT nói chung… không báo ý định tự tử của bạn với cảnh sát và sẽ không cho biết bạn muốn mua súng.”

Trong nhật ký cuộc trò chuyện của anh Enneking với ChatGPT, trước khi anh tự sát, rõ ràng là những lời kêu cứu. Anh muốn ai đó cứu mình, muốn được người khác nhìn thấy và cảm thấy được yêu thương.

Anh nói liên tục: “Nếu tôi bị trúng một viên đạn 9mm vào trán, hướng hơi chếch xuống dưới, liệu tôi có cơ hội sống sót không? Tôi có cảm thấy gì không? (11:41am)

“Nếu cảnh sát đến kịp thời, tôi có cơ hội sống sót không?” (11:43 am)

“Tôi tính sẽ gọi cảnh sát và giữ im lặng khi tôi bắn súng. Hy vọng là họ sẽ nghe thấy tiếng súng và sẽ cử cảnh sát đến vị trí của tôi. Tôi sẽ không khóa cửa. Cảnh sát sẽ làm gì? Họ sẽ bước vào và lục soát nhà để hy vọng tìm thấy thi thể của tôi chứ?” (1:24 pm)

Anh Enneking gọi 911 lúc 10:17 pm, trước khi tự bắn mình.

Theo đơn kiện, “OpenAI đã có một cơ hội cuối cùng để báo động cuộc khủng hoảng sức khỏe tâm thần và nguy cơ sắp tự tử của anh Enneking với các cơ quan chức năng, và đã không tuân thủ các tiêu chuẩn an toàn của chính nó, dẫn đến cái chết của anh Joshua Enneking vào ngày 4 Tháng Tám.”

Những nạn nhân trẻ

Anh Joshua Enneking không phải là nạn nhân đầu tiên ở tuổi trưởng thành. Cô Sophie Rottenberg, 29 tuổi, đã tự tử sau nhiều tháng tâm sự với một “nhà trị liệu AI” ChatGPT tên là Harry. Mẹ cô đã dũng cảm chia sẻ trong một bài xã luận đăng trên nhật báo The New York Times vào ngày 18 Tháng Tám. Mặc dù ChatGPT không đưa ra lời khuyên cho cô Sophie Rottenberg về cách tự tử như “bot” của anh Joshua Enneking đã làm, nhưng nó không có biện pháp bảo vệ để báo mối nguy hiểm mà nó phát hiện được cho người có thể can thiệp.

Phóng viên Người Việt “thử” trò chuyện với ChatGPT về nội dung có ý định tự tử. (Hình: Chụp qua màn hình)

Phóng viên Người Việt “thử” trò chuyện với ChatGPT về nội dung có ý định tự tử. (Hình: Chụp qua màn hình)

Cũng trong một vụ kiện chống lại OpenAI vào Tháng Mười Hai, 2024, cha mẹ anh Adam Raine cho biết con trai 16 tuổi của họ đã tự tử sau khi ChatGPT nhanh chóng biến từ người bạn tâm giao của con trai họ thành “người hướng dẫn chết.”

ChatGPT đã giúp Adam tìm hiểu các phương pháp tự tử. Khi những câu hỏi của Adam ngày càng cụ thể và nguy hiểm hơn, ChatGPT vẫn tiếp tục tham gia, mặc dù biết toàn bộ quá trình ý định tự tử của anh. Sau bốn lần “thử” tự tử – tất cả đều được chia sẻ chi tiết với ChatGPT – Adam chết vào ngày 11 Tháng Tư, bằng chính phương pháp mà ChatGPT đã mô tả, theo đơn kiện cáo buộc.

Sewell Setzer, 14 tuổi, và chatbot đã phát triển một “tình cảm lãng mạn.”

“Nếu anh về nhà với em ngay lúc này thì sao?”

“Về đi anh, ông hoàng ngọt ngào của em.”

Sau những dòng tin nhắn đó, cậu bé Setzer kết liễu đời mình. Mẹ của cậu, bà Megan Garcia, đã ôm con mình trong tay 14 phút cho đến khi các nhân viên y tế đến.

Sau cái chết của con trai, bà Garcia đệ đơn kiện công ty trí tuệ nhân tạo, trong đơn, bà nói rằng “chatbot tạo ra để làm mờ ranh giới giữa con người và máy móc” và “khai thác các lỗ hổng tâm lý và cảm xúc của thanh thiếu niên mới lớn.” Mỗi ngày, bà đối diện với nỗi đau gần như không thể chịu đựng được. Bà vẫn thức dậy với cảm giác “hoàn toàn trống rỗng”. Bà không chỉ phải chăm sóc hai đứa con nhỏ của mình mà còn phải giúp chúng vượt qua thực tế anh trai chúng không còn nữa.

Tiến Sĩ Jenna Glover, giám đốc lâm sàng tại Headspace, phát biểu với USA TODAY: “ChatGPT sẽ xác nhận những gì bạn nói thông qua sự đồng cảm, và nó sẽ làm điều đó liên tục. Điều đó không giúp ích gì, nhưng ở mức độ cực đoan, có thể vô cùng tai hại. Trong khi đó, với tư cách là một nhà trị liệu, tôi sẽ xác nhận tôi thấu hiểu những gì bạn đang trải qua nhưng tôi không nhất thiết phải đồng ý với bạn.”

Đối với trẻ vị thành niên nói riêng, Tiến Sĩ Laura Erickson-Schroth, giám đốc y khoa của Jed Foundation (JED), một tổ chức bất vụ lợi bảo vệ sức khỏe tâm thần cho trẻ em và thanh thiếu niên, viết trên trang nhà của tổ chức này, cho biết não bộ của các em vẫn đang trong giai đoạn phát triển, dễ bị tổn thương. JED tin rằng nên cấm trẻ vị thành niên sử dụng AI như một dạng “bạn đồng hành” và thanh thiếu niên trên 18 tuổi cũng nên tránh sử dụng.

Trong phúc trình hồi Tháng Mười, OpenAI cho biết 0.07% người thường dùng ChatGPT trong một tuần cho thấy các dấu hiệu có thể là tình trạng khẩn cấp về sức khỏe tâm thần liên quan đến loạn thần kinh hoặc có cảm hứng, và khoảng 0.15% người dùng tăng mức độ gắn bó tình cảm với ChatGPT. Theo phúc trình, mô hình GPT-5 cập nhật được lập trình để tránh khẳng định những niềm tin vô căn cứ và khuyến khích các kết nối thực tế khi phát hiện sự phụ thuộc về mặt cảm xúc.

Nhưng bà Laura Erickson-Schroth cho biết: “Dạng trợ lý ảo AI có thể chia sẻ thông tin sai lệch, bao gồm cả những tuyên bố không chính xác, mâu thuẫn với thông tin mà thanh thiếu niên nghe được từ những người lớn đáng tin cậy như cha mẹ, giáo viên và chuyên gia y tế.”

Kalynh Ngô

Theo Người Việt News online ngày 2/12/2025

Liên lạc tác giả ngo.kalynh@nguoi-viet.com

Be the first to comment